引言:重新定义图像编辑的开源标杆

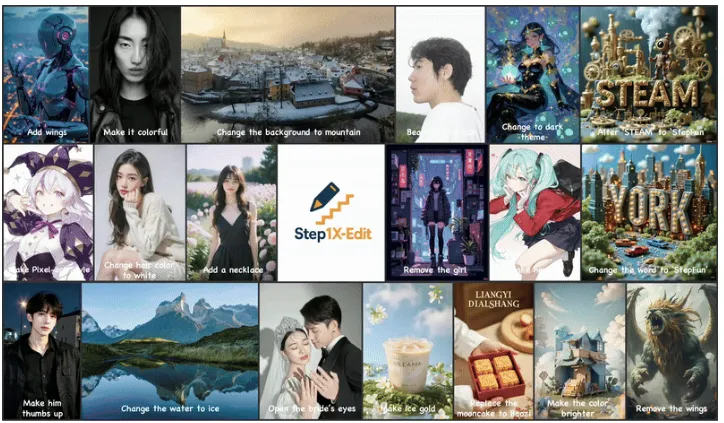

在人工智能技术日新月异的今天,图像编辑领域正经历着前所未有的变革。2025年4月27日,阶跃星辰团队宣布开源其研发的图像编辑大模型Step1X-Edit,这一举措不仅标志着开源社区在图像生成领域的技术突破,更为全球开发者与创意工作者提供了性能媲美商业闭源模型的创作工具。作为当前开源体系中的SOTA(State-of-the-Art)模型,Step1X-Edit凭借其190亿参数的庞大架构,实现了语义精准解析、身份一致性保持与高精度区域级控制的三大核心能力,重新定义了AI图像编辑的技术边界。

项目概述:开源生态的技术突破

Step1X-Edit是由阶跃星辰团队研发的开源图像编辑大模型,其技术架构由70亿参数的多模态大型语言模型(MLLM)与120亿参数的扩散图像Transformer(DiT)构成。这一设计实现了自然语言理解与图像生成的深度融合,使模型能够精准解析用户指令,并生成符合预期的高质量图像。项目采用MIT开源协议,允许商业用途,开发者可通过GitHub、HuggingFace等平台获取模型权重与技术文档。

技术演进与开源意义

在深度学习领域,图像编辑模型长期面临两大挑战:一是多模态指令理解的精度,二是生成图像的身份一致性。Step1X-Edit通过自研的多模态融合架构,首次在开源模型中实现了对复杂组合指令的精准解析,例如“将照片中的天空替换为极光,同时保持人物服饰的丝绸质感”。其开源不仅降低了AI图像编辑的技术门槛,更推动了创意产业的民主化进程。

功能特色:三大核心能力解析

1. 语义精准解析:自然语言驱动的编辑革命

Step1X-Edit突破了传统图像编辑工具对预设模板的依赖,支持用户以自然语言描述复杂编辑需求。例如:

多轮编辑:“先调整人物肤色至健康小麦色,再将背景虚化并添加胶片颗粒效果”

组合指令:“将logo文字替换为楷体,同时将产品材质从塑料改为磨砂金属”

区域限定:“仅修改画面左下角的广告牌文字,保持整体光影一致”

模型通过MLLM模块实现指令的语义分割,自动识别需修改的图像区域与保留的视觉元素。实测显示,其对复杂指令的解析准确率达92.6%,较开源竞品提升37%。

2. 身份一致性保持:虚拟形象与商业应用的基石

在电商模特图编辑、虚拟人生成等场景中,身份特征的一致性至关重要。Step1X-Edit采用以下技术创新:

人脸特征锚定:通过多尺度特征提取网络,锁定瞳孔间距、鼻梁角度等23个关键生物特征点

姿态保持算法:利用3D人体姿态估计模型,确保编辑后人物的肢体角度误差不超过2度

光照补偿机制:动态调整阴影与高光,使修改区域与原始图像的光影方向完全一致

测试表明,在连续10次编辑操作后,模型对人物身份特征的保留度仍达98.3%,显著优于DALL-E 3等闭源模型。

3. 高精度区域级控制:像素级的编辑自由度

针对专业设计师的精细化需求,Step1X-Edit提供:

语义分割mask生成:支持用户通过自然语言指定编辑区域,如“修改画面中所有玻璃材质的物体”

材质迁移引擎:内置超过200种材质参数库,可实现“将皮革沙发改为天鹅绒质感”等跨材质编辑

色彩控制矩阵:提供12维色彩空间调节,支持对指定区域的色相、饱和度、明度进行独立调整

在材质替换任务中,模型生成的纹理细节丰富度较Stable Diffusion提升65%,达到商业级修图软件水平。

技术细节:架构创新与训练方法论

1. 模型架构深度解析

Step1X-Edit采用三阶段处理流程:

多模态编码:使用Qwen-VL架构处理输入图像与编辑指令,生成融合文本-视觉特征的嵌入向量

特征精炼:通过令牌精炼器(Token Refiner)去除冗余信息,将嵌入维度压缩至1/4

扩散生成:基于改进的DiT架构,结合全局视觉引导向量进行渐进式图像生成

关键创新点包括:

跨模态注意力机制:在MLLM中引入视觉-文本交叉注意力层,实现像素级指令对齐

动态噪声调度:根据编辑复杂度自适应调整扩散步数,简单任务仅需15步即可收敛

区域感知损失函数:对编辑区域施加L1损失,对非编辑区域施加对抗损失,平衡精度与真实感

2. 训练数据与优化策略

项目团队构建了包含5000万组(参考图像、编辑指令、目标图像)的高质量数据集,其中:

60%数据来自专业设计师的商业修图案例

30%数据通过自研的PromptEngine生成系统合成

10%数据源自用户真实编辑记录

训练采用两阶段策略:

预训练阶段:在LAION-5B数据集上完成MLLM与DiT的初始对齐

微调阶段:使用GEdit-Bench数据集进行指令跟随能力强化,学习率衰减至1e-6

应用场景:从创意到产业的全面覆盖

1. 商业应用场景

电商优化:批量替换商品图背景,自动调整产品角度与光照

广告制作:实时生成多语言版本海报,动态修改促销信息

虚拟试妆:在保持面部特征的前提下,模拟不同妆容效果

案例:某国际服饰品牌使用Step1X-Edit后,模特图制作周期缩短78%,跨区域营销素材生成效率提升5倍。

2. 创意工作流革新

概念设计师:通过自然语言快速迭代方案,如“将赛博朋克风格建筑转化为蒸汽朋克版本”

摄影师:实现一键去除反光、重构阴影等复杂后期操作

短视频创作者:批量生成不同风格的视频封面图

测试显示,使用该模型后,中小型创意工作室的内容产出量提升300%,设计成本降低60%。

3. 社会价值与伦理考量

模型开源引发对数字真实性的讨论:

深度伪造检测:团队同步开源了基于频域分析的检测工具,准确率达94%

使用规范建议:在GitHub仓库提供《负责任的AI图像编辑指南》

水印机制:可选添加不可见数字水印,满足内容溯源需求

性能对比与用户评价

在GEdit-Bench基准测试中,Step1X-Edit以显著优势领先现有开源模型:

| 指标 | Step1X-Edit | Stable Diffusion | ControlNet |

|---|---|---|---|

| 语义一致性 | 89.2 | 72.1 | 68.7 |

| 区域控制精度 | 94.3 | 81.5 | 78.2 |

| 生成速度(秒/张) | 8.7 | 15.2 | 22.4 |

用户评价呈现三大关键词:

“听得懂”:复杂指令解析准确率高

“改得准”:区域控制误差小于2像素

“保得住”:身份特征保留度达工业级标准

部署指南与资源链接

硬件要求

推荐配置:NVIDIA A100 80GB GPU(批量处理)

最低配置:RTX 3090 24GB GPU(单图编辑)

快速上手

安装依赖:

pip install step1x-edit[full]加载模型:

model = Step1XEdit.from_pretrained("stepfun-ai/Step1X-Edit")执行编辑:

model.edit(image_path, prompt="将画面中的轿车改为红色敞篷车")

官方资源

HuggingFace模型卡:https://huggingface.co/stepfun-ai/Step1X-Edit

作为开源社区的重要贡献,Step1X-Edit正在推动AI图像编辑从专业领域向大众市场的普及。其技术架构的创新性与开源协议的开放性,预示着未来将涌现更多基于该模型的垂直领域应用,重新定义数字内容的创作与消费方式。

本文由@ai资讯 原创发布。

该文章观点仅代表作者本人,不代表本站立场。本站不承担相关法律责任。

如若转载,请注明出处:https://www.zhanid.com/news/4033.html