一、Oli是什么?

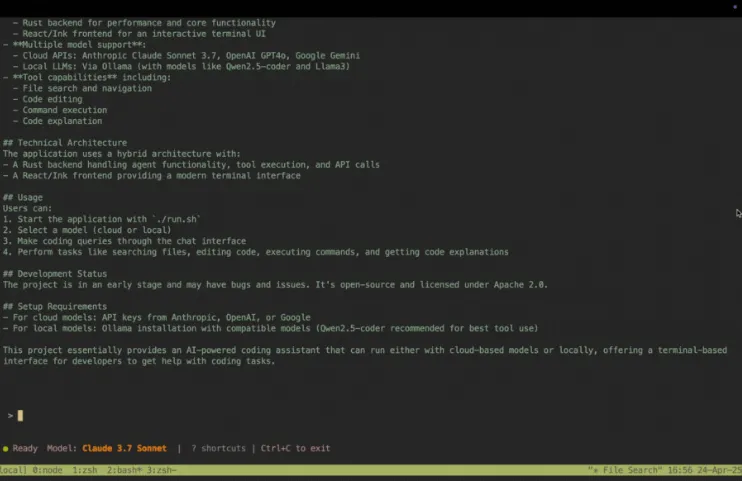

Oli是一个开源的终端AI编程助手,旨在通过结合云API与本地大语言模型(LLM)的强大能力,为开发者提供高效、灵活的编码辅助工具。其核心目标是简化开发流程,提升编码效率,并支持从简单查询到复杂任务的全生命周期管理。Oli的特点包括:

混合架构:Rust后端提供高性能与可靠性,React/Ink前端构建现代化终端界面;

多模型支持:兼容Anthropic Claude、OpenAI GPT-4o、Google Gemini等云端模型,以及通过Ollama部署的本地模型(如Qwen 2.5 Coder、Llama 3);

代理功能:支持文件搜索、代码编辑、命令执行等自动化操作;

工具集成:无缝对接Git、Shell、代码解析器等开发工具;

开源与可扩展:用户可自由修改代码、扩展功能,并选择适合自身需求的模型配置。

Oli的设计哲学是“让AI成为开发者的第二大脑”,尤其适合需要快速迭代、处理复杂任务或偏好终端环境的开发者。

二、功能特色

1. 高性能混合架构

Rust后端:负责核心逻辑处理,包括:

Agent功能:任务调度、文件系统交互、工具执行;

API通信:通过JSON-RPC协议与云端模型或本地Ollama服务交互;

错误恢复:内置重试机制与异常处理,保障长时间运行的稳定性。

React/Ink前端:提供沉浸式终端UI,支持:

动态布局:自适应窗口大小,实时显示代码片段、搜索结果和日志;

交互式输入:支持Tab补全、命令历史回溯和上下文感知建议;

动画效果:平滑的加载动画与状态反馈,提升用户体验。

2. 多模态模型兼容

云端模型集成:

Anthropic Claude 3.7 Sonnet:默认推荐模型,支持结构化JSON输出与复杂推理;

OpenAI GPT-4o:擅长自然语言理解和创意生成;

Google Gemini:在数学与科学任务中表现优异。

本地模型部署:

Ollama支持:一键拉取Qwen 2.5 Coder、Llama 3等模型,满足隐私与离线需求;

工具调用优化:针对支持函数调用的模型(如Qwen 2.5 Coder)进行指令微调,提升代码生成准确性。

3. 智能化代理功能

文件系统操作:

智能搜索:通过自然语言查询快速定位文件(如“列出所有导入anyhow库的Rust文件”);

上下文感知编辑:自动读取文件内容并建议修改(如“将这段Python代码改为异步模式”)。

命令执行:

Shell集成:直接在终端内运行git commit、cargo build等命令;

安全沙箱:限制敏感操作(如rm -rf)需用户二次确认。

跨工具协作:

Git集成:自动解析提交信息并生成变更日志;

文档生成:通过工具调用自动生成API文档(如结合rustdoc)。

4. 开发者友好特性

代码解析与解释:

代码摘要:输入“解释这段代码的作用”自动生成技术文档;

错误诊断:识别编译错误并提供修复建议(如“未找到模块:提示安装缺失依赖”)。

个性化配置:

模型切换:通过配置文件或UI界面动态选择云端或本地模型;

插件扩展:支持自定义脚本与工具链集成(如部署到Vercel或Docker容器)。

三、技术细节

1. 架构设计

分层通信:

前端(React/Ink):处理用户输入与UI渲染,通过WebSocket与后端保持实时同步;

后端(Rust):接收请求后分解为子任务(如“调用模型”“执行Shell命令”),并通过异步任务队列管理流程。

JSON-RPC协议:统一前后端通信格式,支持以下方法:

{ "jsonrpc": "2.0", "method": "agent.query", "params": { "model": "claude-3.7-sonnet", "prompt": "生成一个Node.js REST API框架" }, "id": 1 }

2. 性能优化

Rust的优势:

内存安全:避免常见的内存泄漏与竞态条件;

并发处理:利用Tokio异步框架实现多任务并行(如实时搜索与代码生成同时进行)。

缓存机制:

文件指纹缓存:通过哈希值检测文件变动,避免重复解析;

响应缓存:对相同查询的模型结果进行本地缓存(TTL可配置)。

3. 安全与隐私

本地模型部署:通过Ollama运行私有模型,确保数据不被云端传输;

敏感操作拦截:自动检测并警告潜在危险命令(如rm -rf /);

审计日志:记录所有模型调用与文件操作,便于追溯与合规审查。

四、应用场景

1. 日常编码场景

代码生成:快速实现算法逻辑或API接口(如“用Rust实现一个LRU缓存”);

调试辅助:自动定位错误根源并提供修复方案(如“未捕获的Promise错误”);

文档编写:自动生成函数注释与README文件(如“根据代码结构生成TypeScript接口文档”)。

2. 复杂任务处理

架构设计:通过自然语言描述生成系统架构图(如“设计一个分布式消息队列”);

代码重构:批量修改代码风格或迁移框架(如“将React Class组件转为Hooks”);

性能优化:分析代码瓶颈并提出改进建议(如“优化Python循环的向量化操作”)。

3. 学习与协作

代码解释:理解开源项目中的复杂逻辑(如“解释这段TensorFlow模型的训练流程”);

团队协作:自动生成代码评审意见或合并请求描述;

知识管理:构建个人知识库,通过问答形式快速检索历史代码片段。

五、相关链接

GitHub仓库:https://github.com/amrit110/oli

项目官网:Oli官方文档

六、总结

Oli作为一款终端AI编程助手,通过高性能架构、多模型兼容与智能化代理功能,显著提升了开发者的工作效率。其核心优势在于:

灵活性:用户可根据需求自由切换云端与本地模型,平衡速度与隐私;

深度集成:与Git、Shell等工具无缝协作,覆盖编码全生命周期;

开源生态:鼓励社区贡献,支持自定义扩展与私有化部署。

尽管Oli目前仍处于早期阶段(标记为alpha版本),但其潜力已初步显现。未来计划增加以下功能:

多模态支持:集成图像识别与图表生成(如通过Stable Diffusion生成UML图);

实时协作:支持多人共享编辑会话与代码评审;

强化学习:通过用户反馈持续优化模型响应质量。

对于开发者而言,Oli不仅是一个工具,更是一个可成长的智能伙伴。它降低了AI的使用门槛,让编码变得更加直观与高效。随着社区的壮大与功能的完善,Oli有望成为终端环境中不可或缺的AI助手。

本文由@ai资讯 原创发布。

该文章观点仅代表作者本人,不代表本站立场。本站不承担相关法律责任。

如若转载,请注明出处:https://www.zhanid.com/news/4158.html