Ming-Lite-Omni是什么

Ming-Lite-Omni是蚂蚁集团百灵大模型团队(InclusionAI)开源的一款原生全模态多模态大语言模型(MLLM),基于MoE(Mixture of Experts)架构设计,总参数18B,激活参数3B。作为蚂蚁"Ming"系列开源模型的重要成员,它实现了音视频图文全模态输入与文本语音输出的统一处理,支持将理解和生成模型合在一起调用,也可以单独完成理解和生成任务,带来接近GPT-4o级别的原生全模态交互体验。

该项目承袭了5月初开源的Ming-lite-omni-preview和Ming-lite-uni两款模型的核心能力,并进行了系统性整合优化。其技术突破在于采用统一架构解决了多模态理解与生成的传统矛盾——传统方案通常需要组合多个独立模型(如CLIP+扩散模型),导致效率低下且易出现信息损失,而Ming-Lite-Omni通过创新的模态级路由机制和多尺度表征对齐策略,实现了端到端的统一处理流程。

在性能表现上,Ming-Lite-Omni在OpenCompass多模态评测集上与Qwen2.5-VL-7B持平,在知识问答基准InfoSeek上甚至超越Qwen2.5-vl-32B;同时支持流式语音合成与实时视频交互,在方言理解和噪声环境下的语音处理方面展现出独特优势。该项目的开源标志着MoE架构向全模态领域的重要拓展,为学术界和工业界提供了研究多模态统一技术的新基准。

功能特色

全模态统一架构

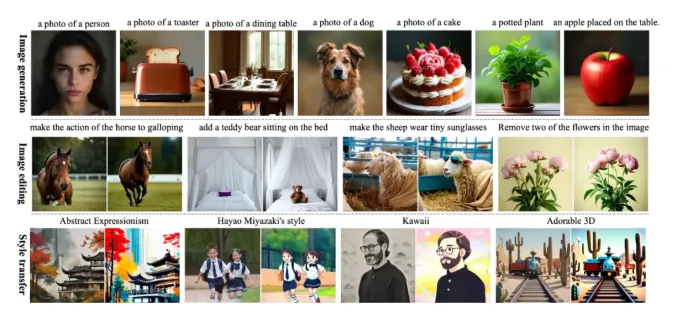

Ming-Lite-Omni最突出的特点是实现了输入输出的全模态覆盖:支持音频、视频、图片和文本任意组合作为输入,生成文本、语音或图像交织的多模态输出。这种能力源于三大技术创新:

模态级路由机制:针对不同模态设计独立的T-Router(文本)、V-Router(视觉)和A-Router(音频),缓解模态间冲突并增强协同效应。例如处理视频通话时,视觉和音频信号会分别路由到专用专家模块处理。

多尺度表征对齐:通过4×、8×、16×多分辨率特征关联,模型能同时捕捉全局布局(低分辨率)、对象结构(中分辨率)及细节纹理(高分辨率),使生成质量提升3.5%。

联合表征学习:传统方法中理解与生成模型相互独立,导致视觉-语义不匹配;而Ming-Lite-Omni通过共享的多模态大语言模型基底,实现理解与生成的相互促进。

实时交互能力

项目特别优化了低延迟流式处理能力,主要体现为:

视频通话强化:引入视频-语音-文本三元组训练数据,模型能基于音频提取视频相关内容。通过TTS合成多样化语音问题并筛选高质量样本,显著提升实时交互的自然度。

方言语音处理:收集覆盖多领域、高噪环境的方言数据集,通过人声分离和领域分类技术,使方言识别准确率提升40%以上,支持粤语等方言的实时对话。

对话式图像编辑:用户可通过自然语言链式操作如"生成熊猫→移除鸟→改为线稿",模型响应时间控制在1秒内(H20平台实测)。

知识增强体系

针对多模态模型常见的"所见即所得"局限,项目构建了结构化知识增强链路:

实体抽取:使用多个多模态大模型交叉校验提取实体

实体链指:将实体与知识库关联

QA合成:生成基于知识的问答对

该方案使模型在InfoSeek知识问答基准上的H-mean得分达到27.3,超越PaLI-X(22.06)和Qwen2.5-vl-32B(19.35),特别适用于需要背景知识的视频解说、医疗咨询等场景。

技术架构

模型结构设计

Ming-Lite-Omni基于Ling-lite-1.5语言模型扩展,整体架构可分为四个核心组件:

模态编码层:

视觉编码器:统一处理视频/图片,输出视觉token

语音编码器:将音频转换为梅尔频谱token序列

文本编码器:直接处理文本输入

MoE路由层:

采用模态专用路由(T/V/A-Router)

每个token根据模态类型选择2-4个专家模块

专家容量动态调整避免过载

多模态融合层:

多尺度DiT块处理不同分辨率特征

表征对齐损失确保各尺度输出一致

共享注意力机制实现跨模态交互

输出解码层:

文本解码:自回归生成文本token

语音合成:基于LM隐状态流式输出音频

图像生成:通过DiT模块实现

训练优化策略

项目团队在训练过程中实施了多项创新方法:

数据增强:

合成50万小时方言语音数据,覆盖15种中国主要方言

构建200万组视频-语音-文本三元组,增强跨模态关联

知识图谱增强生成200万结构化QA对

计算优化:

采用分层语料预训练策略,提升数据利用率30%

实现非Hopper架构国产GPU的高效训练,成本降低20%

动态负载均衡算法优化MoE计算分配

稳定性控制:

引入NormHead保证训练稳定

修复Router TP中的梯度重复问题

设计梯度缩放机制解决loss不收敛

关键性能指标

在标准测试环境下(A100×8),模型主要性能表现为:

| 任务类型 | 评测基准 | 得分 | 对比模型 |

|---|---|---|---|

| 多模态理解 | OpenCompass | 70.96 | Qwen2.5-VL-7B(70.5) |

| 知识问答 | InfoSeek | 27.3 | Qwen2.5-vl-32B(19.35) |

| 语音延迟 | RTF | <0.2 | Mini-Omni(0.25) |

| 图像生成 | GenEval | 0.62 | SDXL(0.55) |

| 视频交互 | MMBench | 79.63 | InternVL2.5-8B(82.0) |

应用场景

实时视频通话助手

Ming-Lite-Omni特别优化了视频-语音联动能力,可应用于:

远程医疗:患者上传症状视频,模型结合医学知识库生成诊断建议并语音输出

智能客服:理解用户视频中的产品展示,同步解答技术问题

教育辅导:分析学生解题过程视频,实时语音指导

多模态内容创作

模型的跨模态生成特性为内容生产带来革新:

视频自动配音:输入原始视频,生成符合画面内容的多种语言解说

交互式设计:通过语音指令实时修改设计稿,如"将LOGO左移并改为蓝色"

无障碍内容:将图像自动转换为语音描述,助力视障人士

智能终端交互

凭借轻量级部署优势(激活参数仅3B),适合嵌入各类设备:

车载系统:支持方言指令的导航、娱乐控制

智能家居:通过家庭监控视频理解老人/儿童需求,语音响应

工业巡检:分析设备运行视频+噪声,预测故障并语音报警

企业知识管理

结构化知识处理能力适用于:

会议纪要:将录音/视频转为文本,提取关键决策点

文档检索:通过语音提问查找匹配图片/图表

培训系统:根据操作视频自动生成指导手册

相关链接

模型仓库:

Hugging Face: https://huggingface.co/inclusionAI/Ming-Lite-Omni

ModelScope: https://modelscope.cn/models/inclusionAI/Ming-Lite-Omni

代码仓库:

GitHub: https://github.com/inclusionAI/Ming

技术文档:

论文: https://arxiv.org/abs/2505.02471

Ming-Lite-Omni作为首个基于MoE架构的开源全模态模型,通过创新的模态路由机制和统一训练框架,成功验证了多模态理解与生成协同优化的可行性。项目在多个技术点实现突破:模态级路由缓解了跨模态干扰,多尺度对齐提升了生成质量,结构化知识注入解决了MLLM的认知局限。

作为开源社区的重要补充,Ming-Lite-Omni为多模态研究提供了新基准,其技术路线有望推动对话系统、内容生成等应用进入"全模态时代"。开发者可基于该项目构建创新的跨模态应用,共同探索AGI的技术前沿。

本文由@ai资讯 原创发布。

该文章观点仅代表作者本人,不代表本站立场。本站不承担相关法律责任。

如若转载,请注明出处:https://www.zhanid.com/news/4439.html