在本地部署大型语言模型(LLM)时,Llama、Ollama和Llama.cpp是三个高频出现的关键词。三者看似关联紧密,但定位与功能差异显著。本文ZHANID工具网将从技术架构、应用场景、性能特点等维度展开详解,帮助开发者选择最适合的部署方案。

一、核心概念解析

1.1 Llama:基础模型架构

Llama(Large Language Model Meta AI)是Meta(原Facebook)开源的系列大语言模型,采用Transformer架构,参数规模从7B到65B不等。其核心特点包括:

开源属性:模型权重和训练代码完全开放(需遵守许可协议)

模块化设计:支持通过调整层数、注意力头数等参数定制模型

社区生态:衍生出Vicuna、Alpaca等微调版本,形成庞大生态

注意:Llama本身仅提供模型权重文件(如.bin或.pth格式),需配合推理引擎才能运行。

1.2 Ollama:模型运行平台

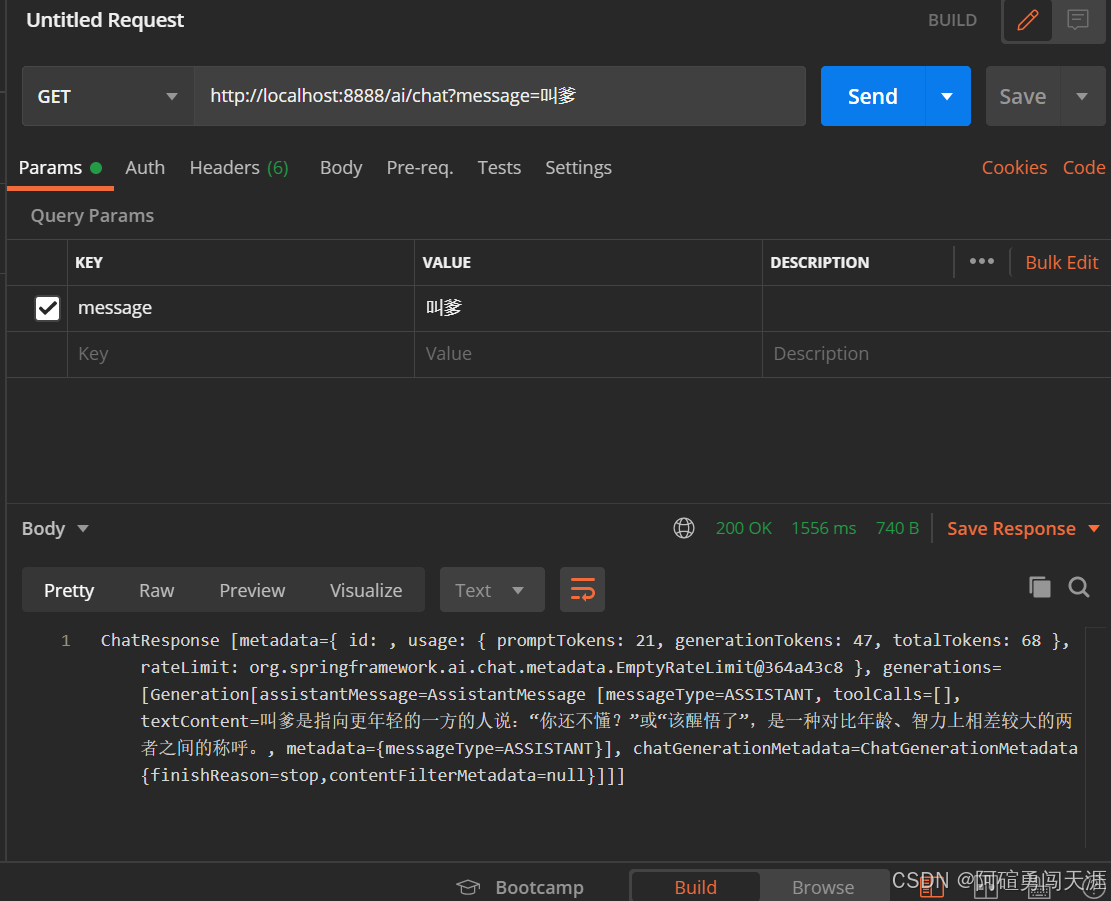

Ollama是一个开源的LLM部署平台,核心价值在于:

统一接口:通过

ollama run命令即可运行模型,隐藏底层实现细节跨模型支持:兼容Llama、Mistral、Phi-3等主流开源模型

附加功能:

模型仓库管理(自动下载/更新模型)

HTTP API接口(支持对话式应用开发)

资源监控(GPU/CPU占用、内存消耗可视化)

典型使用场景:

# 安装模型 ollama pull llama2 # 启动对话 ollama run llama2 --prompt "解释量子计算原理"

1.3 Llama.cpp:CPU优化推理库

Llama.cpp是专为CPU设计的Llama模型推理引擎,核心优势包括:

无依赖部署:纯C++实现,无需CUDA/cuDNN等GPU驱动

量化压缩:支持4/8位整数量化,模型体积缩小75%+

跨平台支持:Windows/macOS/Linux/Android/iOS全覆盖

技术亮点:

GGML格式:自定义模型存储格式,优化内存访问模式

多线程加速:利用OpenMP实现CPU并行计算

移动端适配:在iPhone 15上可实现3 tokens/s的推理速度

二、核心差异对比

| 维度 | Llama | Ollama | Llama.cpp |

|---|---|---|---|

| 定位 | 基础模型架构 | 部署平台 | CPU推理引擎 |

| 硬件依赖 | GPU加速推荐 | GPU/CPU自适应 | 纯CPU运行 |

| 量化支持 | 需第三方工具 | 内置4/8位量化 | 原生支持GGML量化 |

| 扩展性 | 需自行封装API | 提供HTTP API | 需集成到其他框架 |

| 典型延迟 | 50ms/token(GPU) | 80ms/token(GPU) | 300ms/token(CPU) |

| 内存占用 | 16GB+(FP16) | 8GB+(量化模型) | 4GB+(4bit量化) |

三、部署方案选型指南

3.1 场景一:快速原型验证

推荐方案:Ollama

优势:

单命令完成模型下载与运行

内置Web UI和API接口

自动处理模型格式转换

适用场景:

快速测试不同模型效果

搭建本地对话机器人原型

教育/研究用途的模型分析

3.2 场景二:资源受限环境

推荐方案:Llama.cpp

量化对比:

量化精度 模型体积 内存占用 推理速度 FP16 13GB 16GB 50ms/t Q4_0 3.25GB 4GB 300ms/t Q5_1 4.8GB 6GB 200ms/t 优化技巧:

# 使用Q4_0量化运行7B模型 ./main -m ./llama-7b-q4_0.bin -p "你好" -t 8

适用场景:

旧款笔记本电脑部署

移动端APP集成

物联网边缘计算

3.3 场景三:生产级部署

推荐方案:Ollama + GPU

性能调优:

启用CUDA加速:

export OLLAMA_CUDA=1调整Batch Size:

--batch-size 512启用Tensor并行:

--tensor-parallel 4监控方案:

# 查看实时资源占用 ollama serve --metrics

适用场景:

企业内部知识库

高并发客服系统

本地AI助手开发

四、进阶组合方案

4.1 Ollama + Llama.cpp协同部署

graph TD

A[用户请求] --> B{硬件配置}

B -->|GPU>4GB| C[Ollama(GPU加速)]

B -->|CPU设备| D[Llama.cpp(量化模型)]

C --> E[响应结果]

D --> E4.2 混合精度推理

在Ollama中实现FP16+INT4混合精度:

# model.yaml配置示例 parameters: model: llama-2-7b tensor_parallel: 2 precision: fp16_bf16 quantize: q4_0

五、常见问题解决

5.1 报错"CUDA out of memory"

解决方案:

降低

--batch-size参数值启用模型分片:

--load-in-8bit-mpu使用Ollama的

--offload参数卸载部分层到CPU

5.2 Llama.cpp运行缓慢

优化方向:

启用多线程:

-t 4(根据CPU核心数调整)使用MLAS后端:

--mlock开启预计算:

--rope-scaling

5.3 模型输出中文乱码

原因:模型未进行中文分词训练

解决方案:

使用经过中文优化的模型(如Chinese-Llama-2)

在提示词中加入

<中文>标记:prompt = "<中文>解释Transformer架构"

六、未来趋势展望

端侧模型崛起:随着Llama-3-8B等轻量模型的发布,CPU部署将成主流

硬件协同优化:通过OpenVINO/TVM等框架实现CPU指令集优化

安全增强:Ollama v0.3+已支持模型加密与访问控制

联邦学习:基于Llama.cpp的移动端联邦学习框架正在开发中

七、总结

| 工具 | 核心价值 | 最佳适用场景 |

|---|---|---|

| Llama | 基础模型架构 | 学术研究/模型微调 |

| Ollama | 开箱即用的部署平台 | 快速原型开发/企业级应用 |

| Llama.cpp | 极致CPU优化 | 资源受限设备/移动端部署 |

开发者应根据硬件配置(是否具备NVIDIA GPU)、性能需求(延迟/吞吐量)、应用场景(个人使用/生产部署)等因素综合选择。对于大多数用户,建议从Ollama入手体验本地大模型,再根据需求逐步深入Llama.cpp的优化技巧。随着硬件性能提升和模型压缩技术发展,未来本地部署大模型的门槛将持续降低。

本文由@战地网 原创发布。

该文章观点仅代表作者本人,不代表本站立场。本站不承担相关法律责任。

如若转载,请注明出处:https://www.zhanid.com/biancheng/4036.html