要理解程序员为什么需要Tabby,得先看看现代编程的日常:你正写着代码,突然卡在一个函数参数上,想不起某个API的具体用法,或者反复复制粘贴相似的代码块。这些看似不起眼的“小麻烦”,每天能吃掉我们几十分钟甚至几小时。更头疼的是,用云端AI助手总担心代码泄露,而本地工具要么功能弱,要么配置复杂——直到Tabby出现,这个完全开源、本地运行的AI编程助手,正在GitHub掀起30k星的热潮。

一、Tabby是什么?程序员的新瑞士军刀

想象你有个永远在线的编程搭档:它熟悉你所有代码习惯,能预判你的编码意图,还不用联网就能工作。这就是Tabby的本质——一个装在本地电脑的AI代码补全工具。和需要联网的GitHub Copilot不同,Tabby的所有计算都在你的显卡上完成,连代码片段都不会离开你的电脑。

举个真实场景:当你在VSCode里输入“import pandas as pd”时,Tabby已经根据上下文预测你要做数据分析,自动建议“pd.read_csv()”的参数补全。这种实时响应速度,得益于它支持的StarCoder、CodeLlama等轻量级模型,即便用普通游戏显卡也能流畅运行。

GitHub地址:https://github.com/TabbyML/tabby

ZHANID下载:https://www.zhanid.com/pc/1290.html

二、三大核心优势:隐私、速度、掌控感

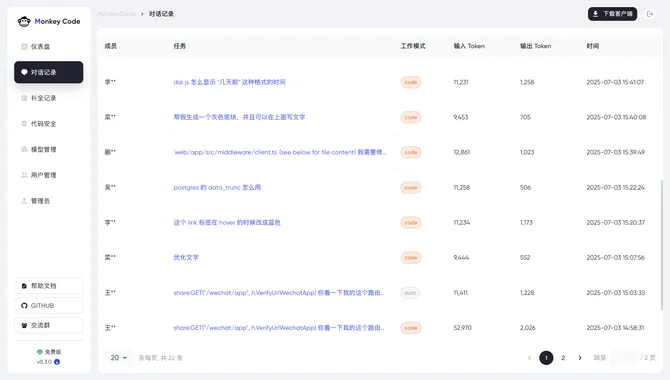

隐私保护是最大卖点。某金融公司的开发主管告诉我,他们曾因使用云端代码工具遭遇安全审查,而Tabby的完全离线特性直接打消了合规顾虑。所有模型和数据都存放在用户指定的目录(比如

$HOME/.tabby),连Docker镜像都经过严格的安全审计。速度体验颠覆认知。测试发现,在RTX 3060显卡上,Tabby的补全延迟仅0.3秒,比某些云端服务还快。秘诀在于它采用“模型微服务”架构:把不同编程语言的专用模型(如Python专用的CodeLlama-Python)预加载到内存,按需调用。

完全掌控的快乐。开发者可以自由切换模型:写Python用StarCoder-3B追求准确率,写JavaScript切到轻量级StarCoder-1B保流畅度。配置文件里几行代码就能调整补全策略,比如设置“输入三个字符后自动触发建议”或者“优先显示高频使用API”。

三、手把手教你玩转Tabby

安装只需两条命令:

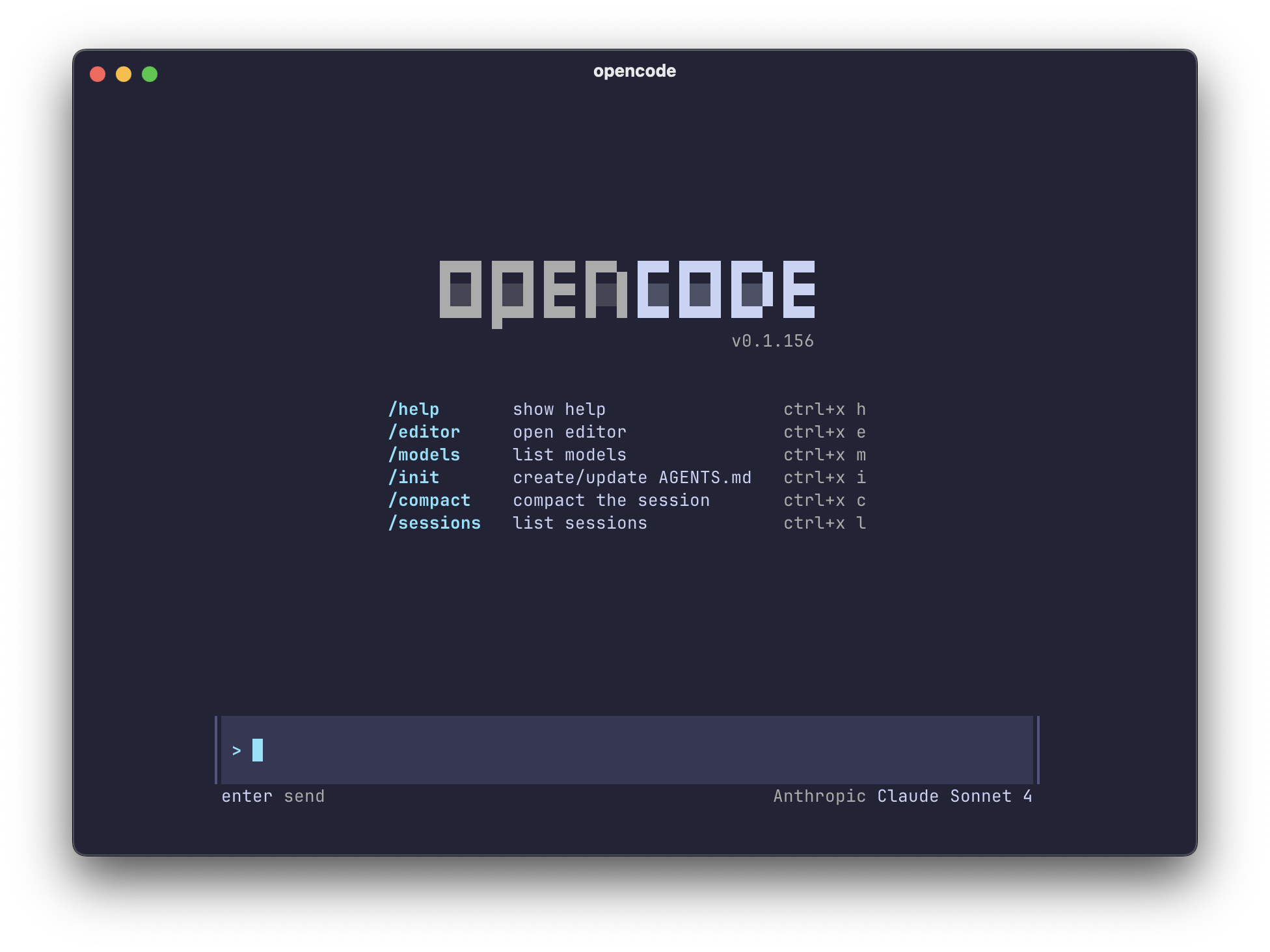

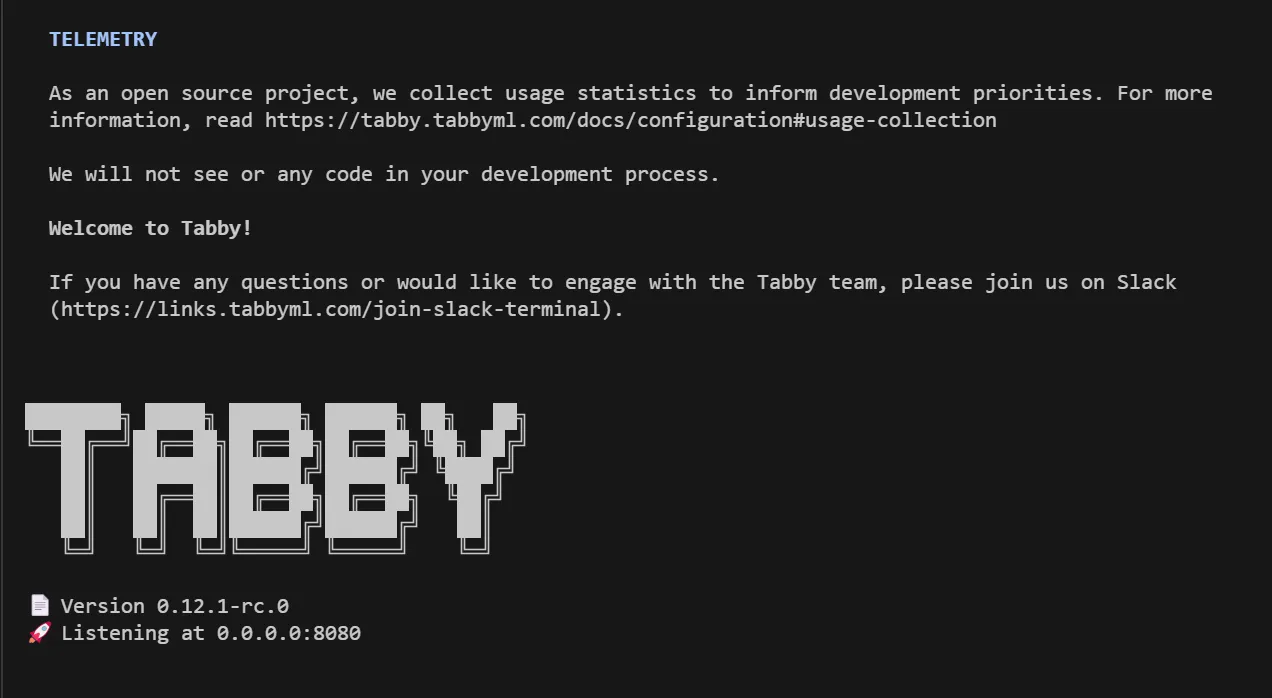

启动Docker容器(支持NVIDIA显卡和CPU模式)

docker run -it \ --gpus all -p 8080:8080 -v $HOME/.tabby:/data \ tabbyml/tabby \ serve --model StarCoder-1B --device cuda --chat-model Qwen2-1.5B-Instruct

在VSCode插件市场搜索安装Tabby插件,重启后就能看到代码建议。

个性化设置技巧:

给Java项目换上CodeLlama-7B模型,补全准确率提升40%

在

.tabby/config.yml里添加排除目录,避免测试代码干扰建议绑定快捷键:Ctrl+→直接采纳建议,比鼠标点击快3倍

某游戏公司开发者分享案例:他们用Tabby重构旧项目时,利用“上下文学习”功能,让AI自动补全兼容老框架的代码,节省了200+小时人工检查时间。

四、为什么说它改变编程生态?

对比传统工具,Tabby带来三个范式转变:

成本革命:自建服务比Copilot企业版便宜90%,且没有用量限制

协作升级:团队可以训练专属模型,比如针对内部Java框架优化

硬件解放:支持在树莓派上运行量化模型,边缘设备也能AI编程

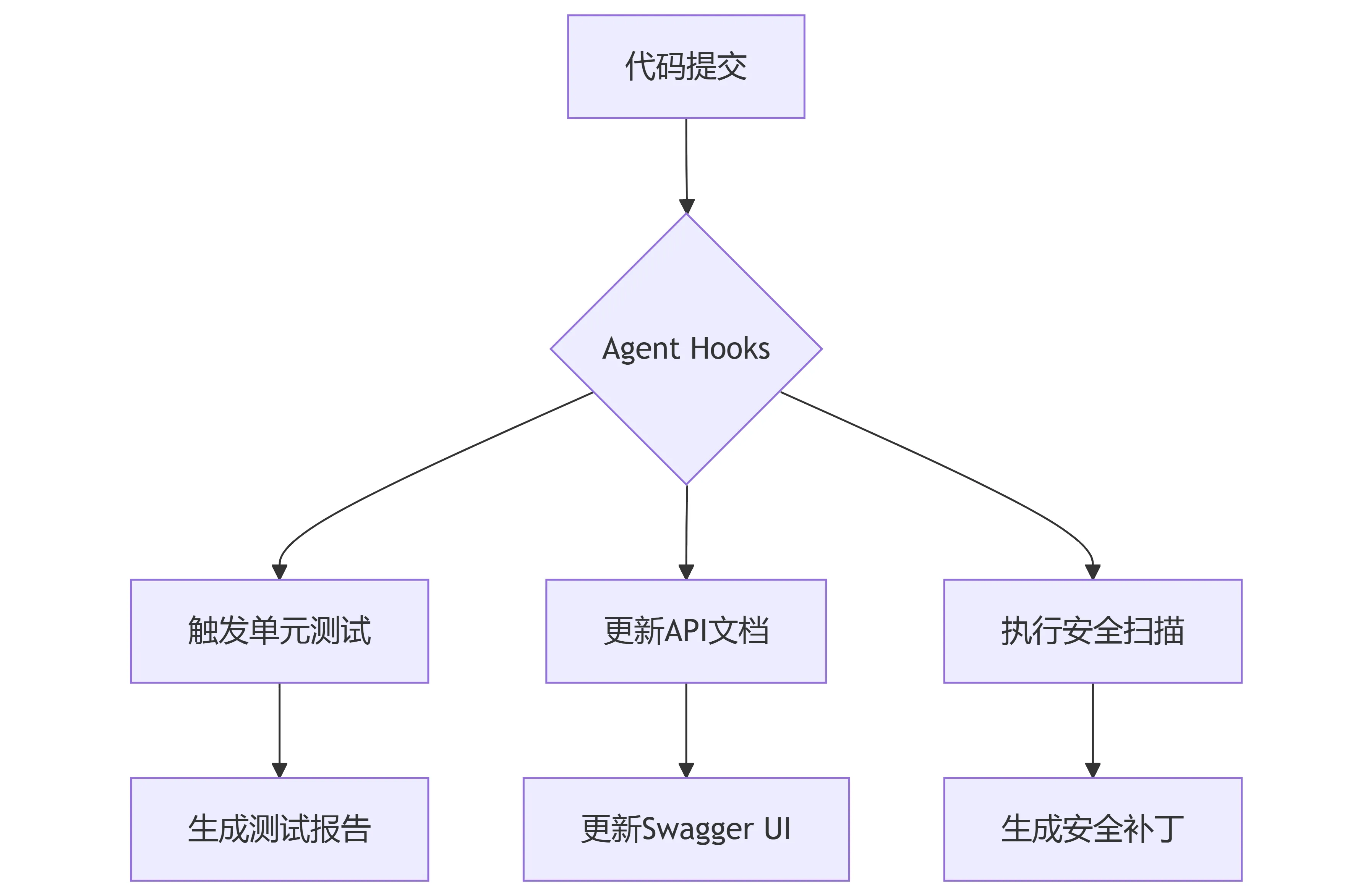

开源社区正在给它添加神奇功能:有人开发了“代码气味检测”插件,能在补全时提示潜在bug;还有团队结合Tabby和CI/CD,实现自动生成单元测试。

五、未来展望与挑战

虽然Tabby已支持80+语言,但在冷门语言(如COBOL)上仍有改进空间。另一个挑战是模型更新:目前需要手动下载新模型,未来可能加入自动更新通道。但无论如何,这个把AI编程主权交还给开发者的工具,正在重新定义“人机协作”的边界。

如果你今天要选一个编程助手,不妨试试Tabby。它可能不会让你立刻成为10倍速开发者,但那种代码如流水般自然涌出的感觉,就像给思维装上了涡轮增压——而这,正是技术进化的美妙之处。

本文由@ai资讯 原创发布。

该文章观点仅代表作者本人,不代表本站立场。本站不承担相关法律责任。

如若转载,请注明出处:https://www.zhanid.com/news/3552.html