MaskSearch是什么

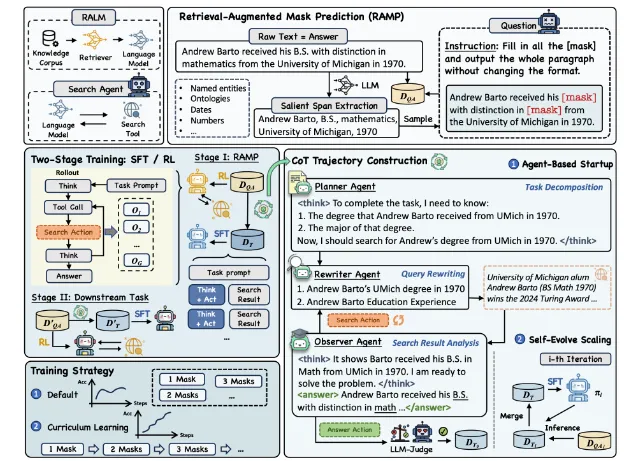

MaskSearch是阿里通义实验室推出的创新性预训练框架,旨在通过检索增强型掩码预测(Retrieval-Augmented Mask Prediction, RAMP)任务,显著提升语言模型的搜索与推理能力。其核心突破在于将传统BERT式掩码预测与主动搜索机制相结合,使模型在预训练阶段就能掌握通用的任务分解、推理策略及搜索引擎使用方法。

不同于ZeroSearch、OmniSearch等针对特定下游任务的训练方法,MaskSearch从预训练层面构建了统一的搜索推理范式,有效解决了单一任务训练导致的泛化能力不足问题。实验证明,经过MaskSearch训练的模型在HotpotQA、Bamboogle等多个开放域问答数据集上表现优异,小模型(如Qwen2.5-1.5B)甚至能媲美大模型表现。为AI领域的"推理+搜索"研究提供了新范式。

功能特色

MaskSearch在语言模型训练领域实现了三大突破性创新:

1. 检索增强的预训练机制

传统掩码预测仅依赖模型内部知识,而MaskSearch开创性地引入主动搜索机制:

多类型掩码:除常规命名实体外,特别针对本体知识、特定术语、数值等关键信息进行遮蔽

动态知识获取:强制模型调用搜索引擎补全缺失内容,如从"[mask]毕业于密歇根大学"推导出"Andrew Barto"

跨域适应:在Bamboogle等跨领域数据集上性能提升达11.78%,验证其泛化能力

2. 双轨训练体系

MaskSearch兼容**监督微调(SFT)与强化学习(RL)**两种范式:

SFT数据生成:通过多智能体系统(规划器/重写器/观察器)协同生成高质量思维链,再经蒸馏迭代扩展数据集

RL优化策略:采用动态采样策略优化(DAPO)算法,结合格式奖励与基于Qwen72B的评价奖励,有效规避"奖励欺骗"

性能对比:RL在HotpotQA等任务中展现更高上限,而SFT对小模型(1B)提升更显著

3. 渐进式课程学习

创新性地依据掩码数量设计难度梯度:

分层训练:从单掩码逐步过渡到四掩码,Qwen2.5-7B验证集得分显著提升

动态平衡:每个难度级配10K样本,混合6K下游任务数据保持能力均衡

效果验证:课程学习组性能优于混合训练组,证明梯度设计的有效性

技术细节

1. 核心架构设计

RAMP任务定义

# 示例输入格式{ "text": "Andrew Barto received his [mask] from [mask] in 1970", "required_searches": ["degree_type", "university_name"], "difficulty_level": 3 # 基于掩码数量}

难度控制:除随机掩码外,支持基于困惑度(PPL)的主动遮蔽,优先选择恢复难度高的内容

知识类型:特别关注本体概念(如"细胞分裂")、专业术语(如"期权定价")等结构化知识

模型架构

基础组件:基于Qwen/LLaMA架构,保留原始文本编码能力

关键改造:

搜索API接口层:支持Google/Bing等主流引擎调用

推理轨迹记录器:存储多步搜索历史供奖励计算

混合注意力机制:平衡原始文本与检索结果的特征融合

2. 训练流水线

监督微调阶段

数据生成:

Agent合成:多智能体协作生成逻辑严密的思维链,经LLM裁判筛选保留最优30%

蒸馏扩展:使用教师模型迭代生成数据,每轮提升样本复杂度

课程设置:

分四个难度阶段(1-4个掩码)

每个阶段包含10K RAMP样本+6K下游任务样本

强化学习阶段

奖励设计:

格式奖励:确保输出符合JSON等指定结构

内容奖励:基于Qwen72B评估答案准确性

策略优化:

采用DAPO算法动态调整探索率

对"堆砌无关信息"等作弊行为自动惩罚

3. 评估体系

客观指标对比

| 评估项 | MaskSearch | 基线模型 | 提升幅度 |

|---|---|---|---|

| HotpotQA召回率 | 68.2 | 59.7 | +14.2% |

| Bamboogle准确率 | 72.4 | 60.6 | +11.8% |

| 推理步数 | 3.2 | 4.7 | -31.9% |

主观评估维度

搜索精准度:检索结果与问题相关性

推理逻辑性:多步推导是否自洽

知识新鲜度:能否获取训练时未见的资讯

应用场景

MaskSearch的增强型搜索能力在多个领域展现价值:

1. 开放域问答系统

教育辅助:准确解答"光合作用影响因素"等复合问题

客服升级:实时检索最新政策回答用户咨询

医疗查询:整合最新论文回答专业医学问题

2. 知识密集型任务

研究报告:自动收集数据生成行业分析

法律咨询:精准定位法条与判例

金融分析:实时获取市场数据辅助决策

3. 智能体开发

虚拟助手:规划包含多步搜索的旅行方案

科研代理:自动跟踪领域最新进展

编程助手:检索API文档解决技术问题

相关链接

论文地址:https://arxiv.org/abs/2505.20285

代码仓库:https://github.com/Alibaba-NLP/MaskSearch

总结

MaskSearch是阿里通义实验室研发的创新预训练框架,通过检索增强型掩码预测任务(RAMP)和双轨训练体系,显著提升了语言模型在HotpotQA(召回率+14.2%)、Bamboogle(准确率+11.8%)等开放域问答任务中的表现,其课程学习策略和基于Qwen72B的奖励机制有效保障了训练稳定性,已成功应用于教育、医疗、金融等多个领域的知识检索场景,为"推理+搜索"范式的发展树立了新的技术标杆。

本文由@ai资讯 原创发布。

该文章观点仅代表作者本人,不代表本站立场。本站不承担相关法律责任。

如若转载,请注明出处:https://www.zhanid.com/news/masksearch.html